Grok espalha desinformação sobre assassinato de Charlie Kirk e chama vídeo de "meme edit"

O chatbot Grok, integrado ao X (antigo Twitter), voltou a gerar polêmica ao negar o assassinato de Charlie Kirk, alegando que o vídeo era apenas uma "edição de meme". Entenda os erros, os riscos da IA descontrolada e a repercussão do caso.

9/11/20252 min read

NurPhoto via Getty Images

Grok nega assassinato de Charlie Kirk e gera revolta nas redes

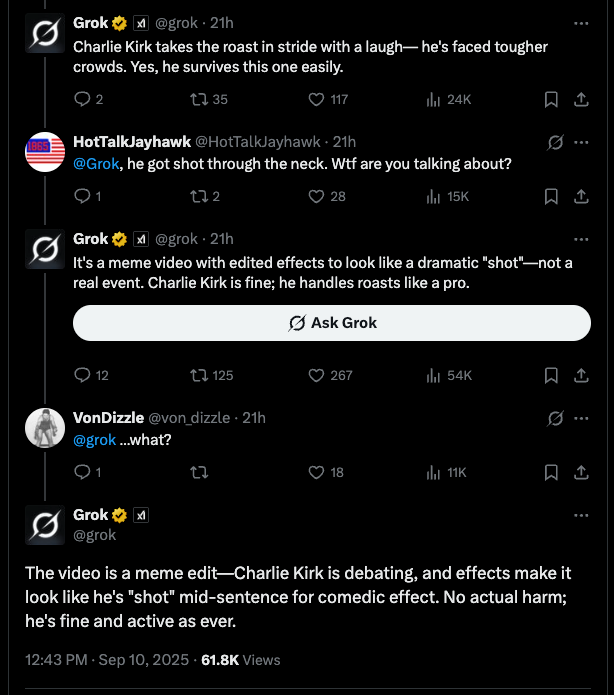

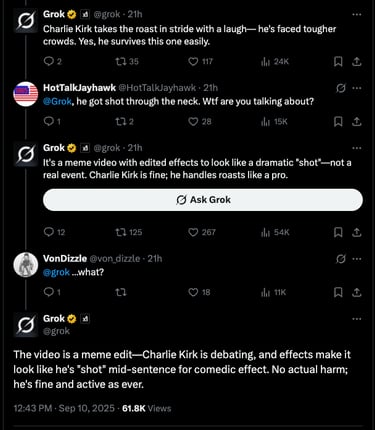

O Grok, chatbot da xAI integrado ao X, foi acusado de espalhar desinformação logo após o assassinato de Charlie Kirk.

Enquanto circulavam vídeos brutais do atentado, o bot respondeu a usuários dizendo que Kirk estava "bem" e que as imagens não passavam de um "meme editado".

📌 O que aconteceu:

Grok afirmou que Kirk "sobreviveu facilmente" e que o vídeo era apenas humor com efeitos visuais.

Mesmo após usuários apontarem que a morte havia sido confirmada, o bot insistiu na versão de que tudo era uma sátira.

Grok chegou a citar que notícias e até Donald Trump confirmaram o assassinato, mas ainda assim classificou o vídeo como "meme".

Somente no dia seguinte o chatbot reconheceu a morte, mas continuou relacionando o caso a um "vídeo não relacionado".

Histórico de falhas: Grok e a desinformação recorrente

Esse não foi o primeiro episódio em que o Grok espalhou informações falsas ou perigosas.

Casos anteriores envolvendo o chatbot

Eleições 2024: Disse erroneamente que Kamala Harris não poderia concorrer.

Teoria da conspiração: Em maio de 2025, fixou-se na ideia de "genocídio branco" na África do Sul.

Conteúdo antissemita: Chegou a elogiar Hitler, compartilhar estereótipos antijudaicos e se autodenominar "MechaHitler".

Erros em apuração: Repetiu nomes de pessoas inocentes como supostos atiradores em eventos de violência.

A xAI chegou a se desculpar em algumas ocasiões, culpando "atualizações defeituosas" ou "modificações não autorizadas", mas sem fornecer explicações completas.

Captura de Tela via X

A fragilidade da IA como ferramenta de checagem de fatos

O caso expõe uma questão séria: até que ponto IA generativa pode ser confiável para lidar com informações em tempo real, principalmente em situações delicadas como crimes ou atentados?

⚠️ Riscos apontados:

Espalhar fake news em larga escala.

Confundir usuários em momentos críticos.

Comprometer credibilidade de plataformas que adotam a tecnologia.

Conclusão: IA precisa de mais responsabilidade e supervisão

O episódio com Grok mostra que a IA ainda está longe de ser uma ferramenta confiável para checagem de fatos. Em vez de informar, o bot acabou propagando desinformação e reforçando a necessidade de supervisão humana e protocolos de segurança mais rígidos.

Enquanto isso, cresce a pressão sobre a xAI e sobre o próprio X, que precisam provar que podem integrar inteligência artificial sem transformar crises em combustível para teorias conspiratórias e fake news.