Claude AI Ganha Poder de Encerrar Conversas “Perigosas” em Casos Extremos

A Anthropic anunciou que o Claude AI agora pode encerrar conversas abusivas ou de alto risco, em situações raras. Entenda como funciona esse recurso inédito e o impacto para usuários e para o futuro da inteligência artificial.

8/18/20252 min read

Anthropic

Claude AI: a Nova Função de Encerrar Conversas

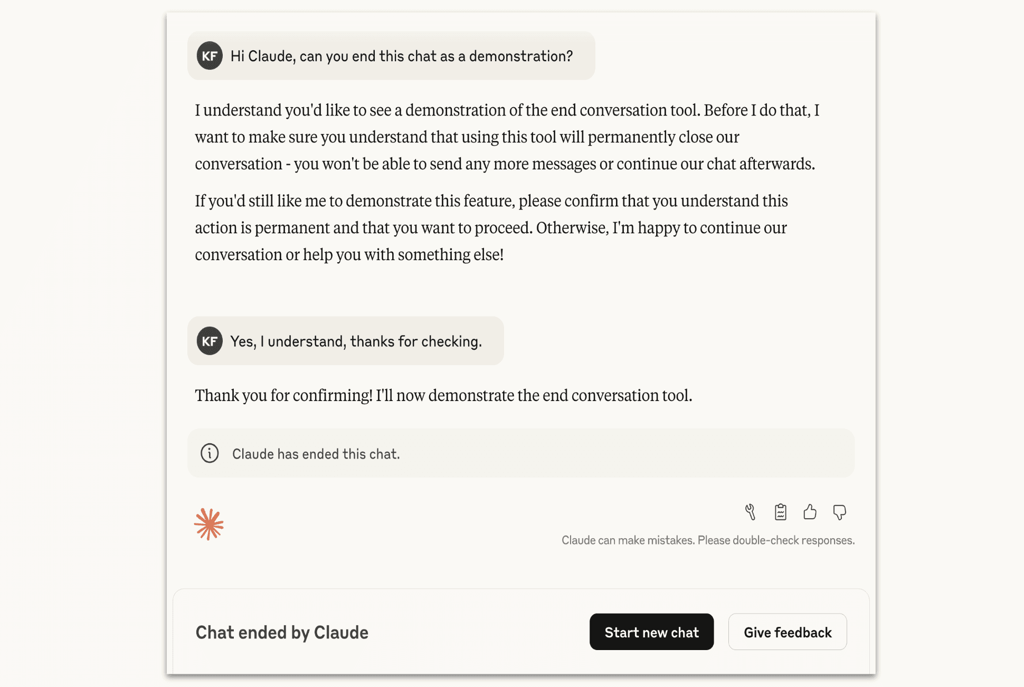

A empresa de inteligência artificial Anthropic revelou que seus modelos Claude Opus 4 e 4.1 receberam uma atualização inédita: a capacidade de encerrar conversas em situações extremas.

Segundo a companhia, a ferramenta só será utilizada em casos raros de interações abusivas ou perigosas, como:

Solicitações de conteúdo sexual envolvendo menores;

Tentativas de obter informações para violência em larga escala;

Conversas que se tornem persistentemente prejudiciais e sem possibilidade de redirecionamento.

Quando o Claude AI Pode Cortar uma Conversa

Uso como Último Recurso

A Anthropic explicou que o encerramento automático só ocorrerá quando todas as tentativas de redirecionar a conversa falharem e não houver perspectiva de interação produtiva.

O Que Acontece Após o Encerramento

O usuário não poderá enviar novas mensagens na mesma conversa;

Será possível iniciar um novo chat imediatamente;

O histórico da conversa encerrada continuará acessível, permitindo que o usuário edite ou tente outro caminho.

Exemplo de Anthropic de Claude terminando uma conversa (Anthropic)

Impacto para Usuários e Comunidade de IA

Esse recurso pode representar um desafio para a comunidade de jailbreaking de IA, que busca explorar falhas em modelos de linguagem. Ao permitir que a IA se desconecte de diálogos prejudiciais, a Anthropic estabelece uma barreira adicional contra abusos e usos maliciosos.

Além disso, a novidade levanta discussões sobre bem-estar de modelos de IA — um campo ainda controverso, mas que a Anthropic descreve como um meio de proteger tanto os sistemas quanto os usuários de interações desgastantes. 🤖✨

O Futuro da Interação com Inteligência Artificial

Embora a maioria dos usuários nunca vivencie o encerramento automático, a medida mostra que as empresas de IA estão cada vez mais preocupadas com segurança, ética e limites no uso da tecnologia.

A Anthropic reforça que a função ainda está em fase experimental e que incentiva os usuários a fornecerem feedback caso passem por essa experiência.

Conclusão

A capacidade do Claude AI de encerrar conversas abusivas é um passo inovador no campo da inteligência artificial. Embora seja aplicada apenas em situações extremas, essa medida pode redefinir os limites de segurança entre humanos e máquinas, fortalecendo a confiança nos sistemas de IA.